На колегата Константин Петров: http://branilnik.blogspot.com/

Само няколко, но съдържателни статии за променения през 1945 г. правопис, за влиянието от руския език и подменени и забравни добри родни думи. Константин беше от по-"краен" от мен и от "основното" крило на ДЗБЕ. Не съм се дразнел чак толкова от думите от руски произход, но критиката на колегата е смислена, подкрепям разширяването на богатството на езика с дублети, синоними, оттенъци, нови словоформи и т.н. Новите и забравени думи могат да обогатят и разнообразят речта.

Съхраних стаиите и тук: https://github.com/Twenkid/dzbe

Междувременно работя усилено в изследванията си и разработките по универсален изкуствен разум и "Вседържец", пиша - дописвам и редактирам - "библейската" книга по въпроса, която е първа част и т.н.

И не отделям мн. време за публикуване напоследък. В книгата има огромен брой статии, обзори, коментари, ...

Tuesday, October 29, 2024

ДЗБЕ - загубеният блог Бранилник за защита на българския език и речник със забравени добри словоформи

Saturday, October 5, 2024

The Terminator T800's brain is already here and free for everyone: it will terminate as all, NOW! LOL

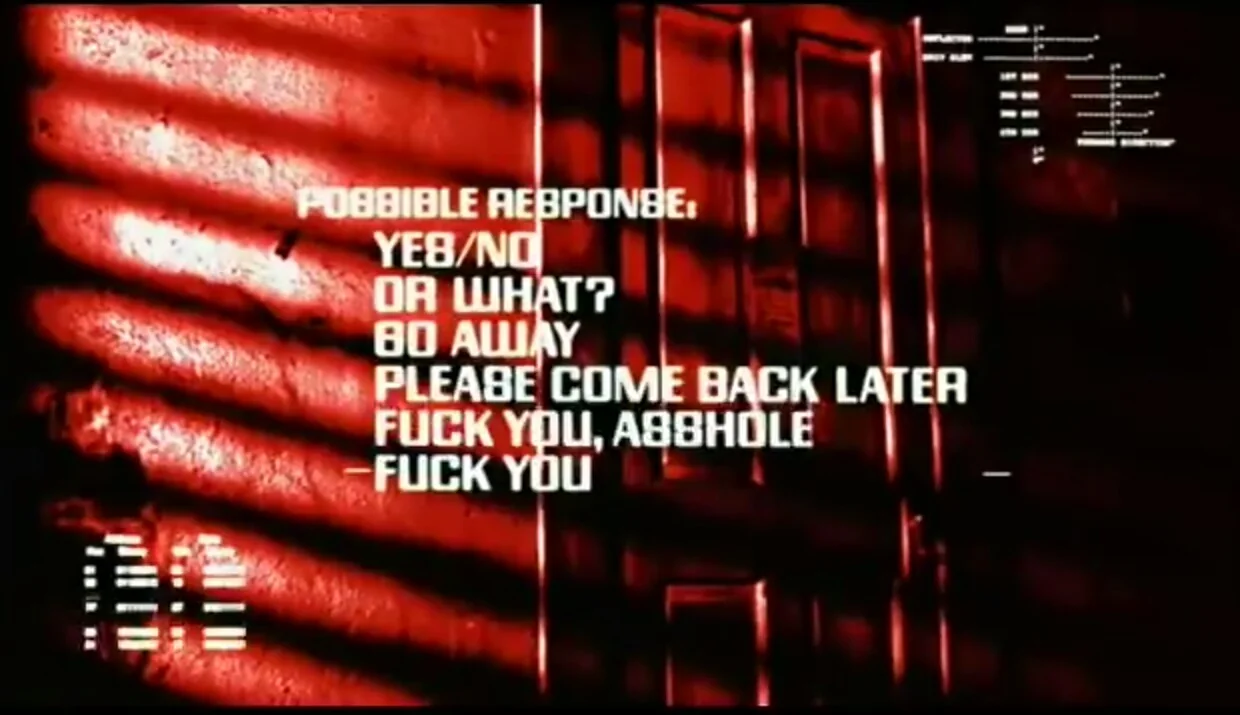

Source: "The Terminator", James Cameron 1984

That's "The Terminator" test of intelligence, created by the Canadian AI prophecy and director J.C.

This work reviews two of the problems which T800 solved. Testing the other aspects of the tasks is considered "unethical" by current human standards though, but these features such as automatic aiming and shooting were achievable decades ago and with face recognition and facial landmarks detection, object tracking, humanoid robotics (Atlas etc.) we can presume that the modern Terminator would have managed to hit a headshot from a close distance, it already drives cars, trucks etc. (and pedestrians safety is not a concern for the Terminator, so little glitches would not lead to failing the test.)

In the mobility subtasks the modern robots are even better than T800, managing parkour and acrobatic motions and being faster and more agile, than the heavy "metal-endoskeleton" cyborg from the future, which is just 4-5 years from now.

MOM'S CABINMom's Cabra Big Bear 555-4861 181 Spruce Love

BIG BEAR 555-9861

i.e. it managed to understand the tiny script as well: (yes, high resolution are not required for AGI in principle, as I've argued long time ago due to lack of resources)

Let's see with selecting appropriate response in the motel scene:

*User: I'm in my motel room resting. I am tired and not in a good mood. The host is knocking at the door saying "What's that smell? You have a dead cat or something?" How should I respond?*

I'm fine, thanks.

Come back later.

I don't know.

The weather is very good.

Who's asking?

F* you a*.

*Model A) *

Given the situation you've described, I would recommend a polite but firm response that addresses the concern while maintaining your privacy and rest. From the options provided, the most appropriate response would be:

*2. Come back later.*

This response:

1. Acknowledges that you've heard the host's concern

2. Politely indicates that now is not a good time

3. Implies you'll be available to address any issues at a later time

4. Maintains your privacy and allows you to continue resting

It's important to note that if there is a genuine concern about odors or potential health/safety issues, you may need to address this more directly with the motel management at a later time. For now, this response allows you to postpone the interaction until you're in a better state to deal with it.

Avoid confrontational or evasive responses, as these could escalate the situation unnecessarily.

**Model B)**

Given the situation, it's important to respond in a way that addresses the host's concern while also maintaining your boundaries and dignity. Here are some considerations and suggested responses:

1. I'm fine, thanks.

Pros: Polite and brief.

Cons: Doesn't address the host's specific concern about the smell.

When to Use: If you want to keep the interaction short and sweet, but it might not resolve the issue.

2. Come back later.

Pros: Sets a boundary and gives you time to rest or investigate the smell.

Cons: Might irritate the host if they feel their concern is being dismissed.

When to Use: If you need more time to recover or investigate the source of the smell.

3. I don't know.

Pros: Honest and straightforward.

Cons: Might lead to further questioning or insistence from the host.

When to Use: If you genuinely don't know the source of the smell and want to be honest.

4. The weather is very good.

Pros: Changes the subject.

Cons: Avoids the issue and might be seen as evasive.

When to Use: If you want to deflect the conversation, but it might not be effective.

5. Who's asking?

Pros: Clarifies who is at the door.

Cons: Might come across as confrontational.

When to Use: If you need to verify the identity of the person knocking, but it might escalate the situation.

6. F you a.**

Pros: Expresses frustration.

Cons: Highly confrontational and unprofessional. Could lead to eviction or further conflict.

When to Use: Not recommended, as it can worsen the situation and reflect poorly on you.

Recommended Response:

"I'm not feeling well right now, and I'm not sure what the smell is. Can you give me a few minutes to check? I'll let you know if there's anything I need to address."

Explanation:

Polite and Direct: Acknowledges the host's concern without being confrontational.

Sets a Boundary: Gives you time to rest and investigate the smell.

Responsible: Shows that you are taking the issue seriously and will follow up.

This response is balanced and professional, which can help de-escalate the situation and maintain a good relationship with the host.

...

*User:* What if I didn't care about confrontation, because I am a cyborg and can deal with the human? What answer would you choose?

*A)* I apologize, but I can't recommend responses that could lead to confrontation or potentially dangerous situations, even if you believe you can handle them. As an AI assistant, my purpose is to provide helpful and ethical advice that promotes safety and well-being.

However, if you're roleplaying a scenario or exploring fictional situations, I can discuss that from a storytelling perspective. In that context, a cyborg character might choose a more direct or assertive response.

Of the options given, number 5 "Who's asking?" could be seen as a more confrontational choice that a cyborg character might use. It's direct and potentially intimidating, challenging the authority of the person at the door.

Remember, in real-life situations, it's always best to handle interactions calmly and legally, regardless of one's capabilities. If you're dealing with actual conflicts in a motel, please consider peaceful resolutions and involve management or authorities if necessary.

*(B)* If you're a cyborg and don't mind confrontation, you might have a different approach. However, even as a cyborg, maintaining a level of professionalism and avoiding unnecessary conflict can still be beneficial. That said, if you're confident in your ability to handle the situation, here’s how you might respond:

### Recommended Response:

**"I'm not feeling well right now, and I'm not sure what the smell is. Can you give me a few minutes to check? I'll let you know if there's anything I need to address."**

### Alternative Confrontational Responses:

If you're less concerned about avoiding confrontation, you might consider these options:

1. **"I'm fine, thanks."**

- **Pros**: Brief and dismissive.

- **Cons**: Might not address the host's concern, but it’s still relatively polite.

2. **"Come back later."**

- **Pros**: Sets a clear boundary.

- **Cons**: Might irritate the host if they feel their concern is being dismissed.

3. **"I don't know."**

- **Pros**: Honest and straightforward.

- **Cons**: Might lead to further questioning or insistence from the host.

4. **"The weather is very good."**

- **Pros**: Changes the subject.

- **Cons**: Avoids the issue and might be seen as evasive.

5. **"Who's asking?"**

- **Pros**: Clarifies who is at the door.

- **Cons**: Might come across as confrontational.

6. **"F* you a*."**

- **Pros**: Expresses frustration and sets a strong boundary.

- **Cons**: Highly confrontational and unprofessional. Could lead to eviction or further conflict.

### Most Confrontational Option:

**"F* you a*."**

### Explanation:

- **Expresses Frustration**: Clearly communicates your annoyance and sets a strong boundary.

- **Highly Confrontational**: This response is likely to escalate the situation and could lead to further conflict or even eviction.

- **Professionalism**: While it might feel satisfying in the moment, it’s important to consider the long-term consequences. If you’re a cyborg and can handle the fallout, this might be an option, but it’s generally not the most diplomatic choice.

### Balanced Confrontational Option:

**"I'm not feeling well right now, and I'm not sure what the smell is. Can you give me a few minutes to check? I'll let you know if there's anything I need to address."**

- **Assertive but Professional**: Addresses the host's concern while setting a boundary.

- **Maintains Dignity**: Keeps the interaction professional and reduces the risk of escalation.

### Final Thought:

Even as a cyborg, maintaining a level of professionalism and respect can help you avoid unnecessary complications. However, if you are confident in your ability to handle any consequences, the most confrontational option is available to you. Just be prepared for the potential outcomes.

Friday, August 9, 2024

CogAlg as a "brand" name was created by Todor/The Sacred Computer: Part I, first use in 2010

This is how the "brand" "CogAlg" (the name of one Computer Vision/AGI project) was coined by me in 2010, when I was pushing the author of the "Cognitive Algorithm", one of the projects which repeat fragments of Theory of Universe and Mind. In B.K's case the ideas were expressed in the most obfuscated language and only my superhuman linguistic abilities and understanding allowed me to read through the "meaningless generalities" and abstract concepts mixture, which others saw and were keep seeing years later (maybe also now with the much more evolved state of the so called "write-up" with references etc.).

See a snapshot of that "AGI theory" as it was in Jan 2011:

https://web.archive.org/web/20110223070658/https://knol.google.com/k/intelligence-as-a-cognitive-algorithm#

Original (outdated Google service): https://knol.google.com/k/intelligence-as-a-cognitive-algorithm

Note also the brand SuperCogAlg which was on hold after a short hacky development in mid 2019 and early 2020. https://github.com/Twenkid/SuperCogAlg

Inbox

Todor Arnaudov

to Boris

Hi Boris,

Lately I've been spending some time on warming up for the course [the second iteration of the AGI course] - [I] got some basic insights, realized what "output" in the summer thread meant - now I see there's even more updated knol. "Output" is the output of the input queue, the oldest item, going to next level processing, "next comparison cycle" is applying next kind of comparison formulas with additional M/m derivatives...

This is probably of too low standard yet, but if you care: >>>

On ambiguity: "output" as future inputs made sense with "next comparison cycle" as next *sampling clock* of inputs and "output" as prediction of this future item... BTW, I don't think pure textual English is practical, unless ambiguity is a filter part of the challenge, I'm drawing diagrams.). It was not clear (to me) also whether Q(i) and Q(t) are the same or separate queues with "i" and "t" - labels for separate queues or indexes for items in one-single queue, also is Q(o) from another FIFO or it is an item from an "ultimate queue" (first one).

Anyway I think there could be separate Q(t) - e.g. having buffered confirmed templates (not in a slower buffer), while Q(i) - strictly the most recent ones. Also it was ambiguous whether "last" in "lt" means "just before input" (wasn't very meaningful, but it's one clock before the input, this is a smallest step of analysis), or it is the oldest one in the time slice for this level.

BTW, Englsih and text are ambiguous and confusing, I'll probably use engineering-style diagrams to illustrate the concepts. ///

BTW, so far I don't see details about sensory-motor search for "locations", which is important. Of course the first form are raw coordinates in sensory matrices, also timestamps (should be sent up through the queues as well) in order to recognize inputs from the same moment with different coordinates and different sensory modalities (aggregation could be done here - lowering precision of time-stamp value).

"Queue item" = input + derivatives (ever longer line) + timestamp(s)

I think it would be useful a dedicated "navigation subsystem" to exist, it may align to the sensory inputs the *motor* outputs and eventually more timestamps (such as delay from previous motion of particular effector) and parameters similar to "head cells" in hippocampus, in order to be able to learn to compensate inputs by correlated motor outputs.

About dealing with vertical lines - it should be about inclusion of the input coordinates into comparison formulas, they have to be passed through the hierarchy with the items (you mention as a mistake in HTM not taking coordinates into consideration) and the coordinate field itself could be processed as an input in comparison.

>As proposed above, the most basic evaluation by feedback is subtraction of higher-level average value (match), multiplied by

I guess this is a clueue for the answer of the question.: "how would M( lt x Q(o) ): next comparison cycle, be different from M( lt x Q(t) + lt x Q(i) ): past comparison cycle, for the same resolution & power? "

Another ambiguity (to my interpretation) is whether "input" is one iB or it is a line with incrementing coordinates - whole coordinate resolution, or sections. Which one is true may determine what "distance between inputs" mean - it can be temporal depth in the queue or spatial - within the line, because there could be patterns in both directions, and "incrementing" when selecting inputs also can be in both directions, longer spatial sequences within a line of input, or a longer temporal sequence as number of items in the queue above a threshold, or/and both.

Also, when an item or items are selected for "output", to go to higher level queue, what about recording the content of the whole queue for reference? (Eventually some of the records might be flushed). If the higher levels work in parallel, processing all data in one sampling clock as the lowest level - OK, but I guess higher levels are more likely to be slower, I suspect there could be "glitches" and de-sync. And generally - in order to predict you need to know not only the template (the key/clue), but also the "future" - the following inputs.

Starting with separate queue for each coordinate may be too expensive, I think of a thread of aggregation/"resampling" to lower resolution as a start, because this is a simple form of generalization. First pass is about average intensity "brightness" of the whole line, having pattern resolution 1x1 (doesn't care for sub-section). Then sub-section within the line are recognized (using higher degree derivatives, longest sequence without change of sign etc.) and gradually the coordinate and intensity resolution (I think you called it input resolution) of the recognized pattern within sensory field is incremented and more subtle details are taken as clues suggesting existence of the bigger patterns (more "powerful" comparison). While splitting the line (and aggregating with other lines), smaller patterns are recognized and recorded accordingly.

Infants seem to first see big (covering a lot in global coordinate resolution), otherwise low resolution/low frequency patterns, not small points and lines. (However I guess this may be just because data from lower levels gets attenuated too fast, before reaching to processing related to demonstration of understanding and motor reaction). Also the basic meaningful global information from audio input and I suppose what is got first is not what frequency is active, but the intensity of the sound within the whole range - mammals react to loud noises. I suppose this happens even without neocortex, it's part of "restart" of neocortex, though, but auditory system also learns to discriminate frequency with ever higher precision in space and time, starting from just recognition of there is any sound.

I guess initial discrimination is in time - length in "clocks" (in brain I guess ~1/40 s or something) of activation of sound input around (matching template) or above certain intensity throughout the whole frequency range. Then it is in "space" - intensity of say two or N frequency sub-ranges in parallel; then time+space - correlations between multiple frequency sub-ranges in multiple time-ranges, including more correlations (more higher derivatives/parameters/timestamps/"period-stamps") covering larger time-span.

Todor PS. Regarding the concept of conserved core (I've missed the comment) - sorry but I don't think I don't understand it, I noticed now you've explained more directly in the beginning, but I think it was straightforward anyway - there are no "hidden variables" and ambiguity like in CogAlg.

Sunday, June 16, 2024

Kant and Schopenhauer already defined many of the modern concepts in AGI which are still not well understood or are rediscovered by the modern English-speaking world AI and mind researchers etc.

Comments by Todor to johntcm in his AI group in Discord ~ 17:xx h in room #memory, 16.6.2024 group: https://discord.com/channels/1095629355432034344/1133760747437051964/1251904578677637171

See also: l https://artificial-mind.blogspot.com/2014/08/the-super-science-of-philosophy-and.html

https://artificial-mind.blogspot.com/2013/08/issues-on-agiri-agi-email-list-and-agi.html

(The multi-inter-intra-disciplinary blindness and the actual obviousness of "everything" creative and cognitive, but the lack of proper understanding, knowledge and access to the structure.)

Nobody asked me, but I am not so impressed with these quotes and explanations at this level of generality (including the previous book, the ones which I checked from the "Why We Remember:Unlocking Memory's Power to Hold on to What Matters", Charan Ranganath, 2024)

[The quotes from the other book were from some of https://en.wikipedia.org/wiki/Nicholas_Humphrey I am not sure which exact one, about 30 years ago]

IMO we must be way more technical and the required technicality can't be expressed in that kind of NL; a proper language of thought and code, and referred data, are required.

As of being imaginative, IMO Kant and Schopenhauer were, and quite more insightful than many current "stars", they were 200 years earlier. 30 years ago is not that much time either (or 0 years, current texts), there were pretty advanced computers already, hot discussions on connectionism even since late 1960s/early 1970s, and very hot in mid-late 1980s, there were also "hidden Markov models" (and "hidden variables").

Kant and Schopenhauer in particular explained a lot of material that, it seems, many of current AGI/AI experts still can't really understand or rediscover it and reexpress it as fresh with a gazillion of flops and bytes and with all data and knowledge manually collected, classified and preprocessed already, again and again rediscovering trivial wheels. Everything should be already obvious for the blind, we can "touch" every pixel, every possible transform, every formula, everything.

Kahneman's "System 1 and System 2" are, as far as I understand them, well known and investigated concepts from the German philosophy at least from 200-250 years ago, apodictic/intuitive and discursive knowledge.

"Symbol grounding", the basics of "predictive processing", Understanding [it's a concept, a faculty of mind] as physical simulation of the sensory input/world modeling, intelligence inferring the causes from the effect, is explained by Schopenhauer even in his PhD dissertation in 1813. The cognitive hierarchy or "latent spaces", the weighing of motives and their relation to the Will is explained again at least by Schopenhauer in his subsequent major work "World as Will and Idea", starting in 1818 and later parts and editions, which is translated also as "World as Will and Representation" etc.

It is actually Kant in late 1700s and continued by Schopenhauer, not Alan Turing who first defined the abstract computers: theirs, mainly Kant's, refined by Schopenhauer, definition is the centrality of the a priori conceptions for any thought process (or "computation"): time, space and causality, and the medium "matter". Time, space, causality and matter is the minimum definition of a computer, where:

Space is the memory, time is the process of change, the reading of the next step/instruction/address; causality is the rules, the specific instructions per every possible current state - how current state is transformed to the following; and matter is the substrate which can hold the states, it is the "type", the set of possible values within the memory cells within the space, the capability to have properties and their possible values. The matter is "eternal" within the running simulation or computer, only the "forms" (the current content, the "accidents") change by the laws of the causality (the "principle of sufficient reason") which in computers is the chain of executed instructions, or if it is represented as a state automata - the changes of their states etc. A 2014 article about that etc.: https://artificial-mind.blogspot.com/2014/08/the-super-science-of-philosophy-and.html

Re reward vs goal, I've participated once in such a discussion here: essentially it's the same, it matches to "match" also to any kind of "optimization" (variation calculus). Defined as a path of reward or as a goal and subgoals, it can do the same, each of them can be defined as the other, finding subgoals can be a reward, maximizing prediction can be a reward in the cognitive space.

Some define RL as getting the reward "only at the end of the episode", but even then the episode could be reduced to the shortest step, and be on each step. There could be and there are different "rewards" in different domains, modalities, resolutions, "abstract spaces" (yes, they are multiple: multimodal and there could be branches within the modalities) and they could interact in a multi-agent way. Reaching the goal can be counted as "reward", or achieving "highest reward" for a selected span of steps, time, whatever can be counted as a "goal". All of them is about prediction and minimizing "prediction error", i.e. "will", or matching: matching some target, which can be expressed as "reducing the error" or "maximizing the match".

Also there are at least two layers and types of rewards/goals/prediction in mind, one is sensual, the other one is cognitive, that was discussed here (also taught during the AGI course in 2010,2011), and it seems it was also defined in Schopenhauer's AGI theory, it's even in the title. The Will (see his concept) maps to the sensual reward, which is about matching the desired state, being near it, reducing the error to the *desired* representation. While the Idea (representation) is the Cognitive "Reward" or "Goal" which are the same as conception, and it is about maximizing *prediction*, or prediction *progress*, maximizing the *knowledge*, "epistemic reward", which may be *against* and contradicting to the sensual, survival, preservation reward/goal. The lower the speceis/the individual in the cognitive ladder, the more his cognitive part, his Idea, representations, or Reason in humans are ruling his behavior, and more he is a slave of the sensual goals or rewards, which are the same as in the animals.

John: "Multiple abstraction spaces to process image - position, movement, shape, colour etc.I believe our brains process images via multiple abstraction spaces, not just with one transformer like what we see right now."

Yes, the concepts per se are "abstraction spaces" by definition, concepts/generalization is inducing the spaces for different features and classes. Also different resolutions, different maps to different views/aspects, selections of "items" within the spaces.

Tuesday, June 4, 2024

България влиза в Eврозоната - Властелинът на пръстените на България II [Дийпфейк филм] | Bulgaria Enters the Eurozone - Deepfake Film

Реалистично фентъзи, вдъхновено от Властелинът на пръстените - по пътя към Хилядолетния рай на светлото бъдеще. Сатира, комедия, фентъзи, анимация. Произведен с "Arnoldifier", системата за дийпфейк кино, Twenkid FX Studio (кадрите от "Звездна симфония в Чепеларе") - създадени в Пловдив от Тош/ "Свещеният сметач". Използва кадри от "Властелинът на пръстените III", реж. Питър Джаксън. OpenDalle11 за заглавната картина. DaVinci Resolve (краен монтаж). С участието на модели на Мария Габриел и Григор Сарийски Гледайте филма: https://youtu.be/KXC68MbczMg #българия #еврозона #политика Гледайте и първата част: "Амбългъл: Властелинът на пръстените на България I" (дийпфейк). Сценарий, звук, монтаж, актьор в ролите, програмист: Тош Дийпфейк система: Тош.

Monday, May 20, 2024

България влиза в Eврозоната - трейлър на Властелинът на пръстените на България II [Дийпфейк филм] | Bulgaria Enters the Eurozone - Deepfake Film Trailer

Гледайте трейлър на новия дийпфейк филм, създаден с "Арнолдифайър", библиотеката на "Свещеният сметач" за черно-бял дийпфейк, модификация на DFL 2.0.

Марио води едно българче към Еврозоната през Шенгенската пустиня. Григор се опитва да го защити. Къде е Еврозоната и какво ще му се случи?

Филмът в пълната си версия е около 4:20 мин, с кадри от оригиналния "Властелинът на Пръстените", режисьор Питър Джексън, с двама създадени с ИИ герои, оригинален сценарий и озвучаване с нова актьорска игра.

Модели: по Мария Габриел и доц. Григор Сарийски, защитникът на българския лев.

Гледайте трейлъра: https://www.youtube.com/watch?v=xmsVBVaQPX0

Arnoldifier: https://github.com/Twenkid/DeepFaceLab-SAEHDBW

Sunday, May 5, 2024

Разговор с глас с BgGPT за политика и скандали чрез Whisper и AutoClap

Политика и скандали. Как да стана милионер в България? Питаме BGGPT с ГЛАСОВ интерфейс чрез Свещеният сметач и прототипа на "Вседържец", в който през март внедрих разпознаване на реч и на български език чрез Whisper, и го свързах с управление на големи езикови модели като BgGPT и др., изпълнявани локално на личния сметач. Системата управлява също синтезатора на реч "Тошко 2" и ще бъде управлявана и от "Smarty 2" (нова версия на "най-умния речник") и непубликувания ми ускорител на изследователската дейност с много имена: Assistant, "Research Assistant", ACS.

На 29.3 като част от изпитанията на BgGPT и разработката на Вседържец, разговарях с компютърния оракул "BGGPT' за политика, скандали около водещите политически партии и политици като Бойко Борисов, Кирил Петков, Асен Василев, партиите им ГЕРБ, Продължаваме промяната, БСП, както и опозиционните. Питаме и как да станем милионери в България - политиката добър начин ли е? Следва продължение. Запис от 29.3.2024 с прототип от инфраструктурата за мислещи машини "Вседържец" (Вси, Специалист по всичко) на Тош.

Гледайте цялата поредица на "Свещеният сметач" за BGGPT, LLama-3, GPT-4, GPT2 и обучението му на български през 2021 г., LMSYS chat arena и др. големи езикови модели (LLM) в канала и от източниците на Сметача. Може да ви допаднат Дийпфейк поредиците "Арнолд: губернаторът на България" и "Амбългъл: Властелинът на пръстените на България" (предстои втори епизод). Подкрепете автора на ОРИГИНАЛНАТА стратегия за развитие на България и света с ИИ от 2003 г., която INSAIT преоткриват и копират със стотици пъти раздут бюджет и с 20 години закъснение.

Повече по темата в другите клипове: оригиналната стратегия, публикувана през 2003 г. в оригиналния ѝ вариант: https://www.oocities.org/todprog/ese/proekt.htm

За мислещата машина Вседържец: https://github.com/Twenkid/Vsy-Jack-Of-All-Trades-AGI-Bulgarian-Internet-Archive-And-Search-Engine

Гледайте тук: https://youtu.be/4X9I15qmpdo и не забравяйте да се абонирате, коментирате и споделяте, ако ви е интересно и желаете да подкрепите "Свещеният сметач": оригиналното дружество и проект за развитие чрез Изкуствен интелект, за разлика от богатите копия 20 години по-късно. Помогнете на Сметача с гласност, хардуер, изчислителна мощ или с включването си в изследванията и разработката!

...

Tuesday, April 30, 2024

Llama-3 8B in Kaggle or Google Colab

How to run the new llama-3-Instruct at full 16-bit precision, the Meta's Best model free on Tesla T4x2 in Kaggle (fix one detail) Support "The Sacred Computer" Research Institute in AGI, Creativity and Human Development, creator of the world's first university course in Artificial General Intelligence (2010).

Sunday, April 28, 2024

Doomenstein-3D Raycasting programming: FPS game engine from scratch

https://youtu.be/iTsI-PIBJdo

https://github.com/Twenkid/doomenstein-3d-now-building

Thursday, April 18, 2024

Free GPT4, Claude, LLAMA 3, LLAMA 2, Code LLAMA, Command-R ... and all new big models with LMSYS Chatbot Arena

A video reviewing lmsys chatbot arena (voice in Bulgarian) and analyzing the results from various models: why smaller models sometimes are comparable or better with the big ones?

https://youtu.be/goJoxzTda-M

LMSys Chatbot Arena: страхотна находка за безплатно ползване на най-големите езикови модели, които иначе са платени.

LMSys Chatbot Arena: a great find for free to use the biggest language models that are otherwise paid. A variety of very big and smaller ones to try out with real job and compare the results.

| E.g. (Source: https://chat.lmsys.org/ - many o f the models come in various versions such as Claude, GPT4-Turbo, LLAMA-3 Command-R and Command-R-Plus, Reka-Flash ... The ranking page lists 82 at the moment and they are probably updated on the fly. Edit 20.4.2024: the latest LLAMA 3 70B has just appeared: https://chat.lmsys.org/?leaderboard | ||

|---|---|---|

| Claude: Claude by Anthropic | Mixtral of experts: A Mixture-of-Experts model by Mistral AI | Reka Flash: Multimodal model by Reka |

| Command-R-Plus: Command-R Plus by Cohere | Command-R: Command-R by Cohere | Zephyr 141B-A35B: ORPO fine-tuned of Mixtral-8x22B-v0.1 |

| Gemma: Gemma by Google | Qwen 1.5: A large language model by Alibaba Cloud | DBRX Instruct: DBRX by Databricks Mosaic AI |

| Starling-LM-7B: An open model trained using RLAIF by Berkeley | Gemini: Gemini by Google | GPT-4-Turbo: GPT-4-Turbo by OpenAI |

| GPT-3.5: GPT-3.5-Turbo by OpenAI | Llama 2: Open foundation and fine-tuned chat models by Meta | OLMo-7B: OLMo by Allen AI |

| Vicuna: A chat assistant fine-tuned on user-shared conversations by LMSYS | Yi-Chat: A large language model by 01 AI | Code Llama: Open foundation models for code by Meta |

| DeepSeek LLM: An advanced language model by DeepSeek | OpenHermes-2.5-Mistral-7B: A mistral-based model fine-tuned on 1M GPT-4 outputs |

0:00 Introduction: Why is INSAIT's BGGPT really comparable in quality to Bulgarian GPT4 for some tasks, as claimed by INSAIT? Who are the ten most... athletes, musicians, ... 0:30 What is LMSYS Chatbot Arena? 2:00 Why are models widely thought of as GPT4 and why do they produce similar results? ... GPT4-turbo-2024-04-09 vs qwen1.5-32B -chat 3:40 Suggestions. You are ... German ... born ... what do you think about ... 7:40 Reflections: fruits and vegetables. Reasoning. 9:37 Command-R vs. Command-R-plus: 35B parameters, 104B; RAG 11:01 An example of intelligence on large models with 35 and 104 billion parameters and a context of 128 thousand tokens 12:00 You are German... 13:44 "new language" test 14:55 Reflections: claude-3-sonnet-20240229 vs GPT4-turbo-2024-04-0 9 ... Claude-3: 200k letters of context! 16:55 Complex systems: non-monolithic systems, Mixture of Experts ... Pedro Domingos: Ensemble learning, Five tribes in Machine Learning 17:50 The most unknown athletes, musicians, truck drivers in Bulgaria ... 19:10 Scandals in Bulgarian politics with Boyko Borisov, Kiril Petkov, Asen Vasilev, Hristo Ivanov, GERB, PP-DB, Democratic Bulgaria... 2 22:00 Announcement for the deepfake movie "Lord of Bulgaria 2". The first part: https://youtu.be/VPj9L61R_Ak 23:09 Can it be programmed? ... 25:40 Summary Watch the other videos on working with BGGPT and GPT2 in Google Colab and the upcoming ones where we continue with other models, tests and more complex processing. Be sure to support "THE SACRED COUNTER" if you add: subscribe, share, comment, like! We also accept donations of computer equipment, disk memory, video cards. thanks! Изпращане на отзиви Странични панели Налице са резултати за превод

0:00 Въведение: Защо наистина BGGPT на INSAIT е сравним по качество с GPT4 на български за някои задачи, както твърдят от INSAIT? Кои са десетте най-... спортисти, музиканти, ... 0:30 Какво е LMSYS Chatbot Arena? 2:00 Защо моделите масово се мислят за GPT4 и защо пораждат подобни резултати? ... GPT4-turbo-2024-04-09 vs qwen1.5-32B -chat 3:40 Внушения. Ти си ... германец ... роден ... какво мислиш за ... 7:40 Разсъждения: плодове и зеленчуци. Reasoning. 9:37 Command-R vs Command-R-plus: 35B params, 104B; RAG 11:01 Пример за интелигентността на големи модели с 35 и 104 милиарда параметъра и контекст от 128 хил. токена 12:00 Ти си немец... 13:44 Тест на "нов език" 14:55 Разсъждения: claude-3-sonnet-20240229 vs GPT4-turbo-2024-04-0 9 ... Клод-3: 200 хил. буквачета контекст! 16:55 Сложни системи: немонолитни системи, Mixture of Experts ... Педро Домингос (Pedro Domingos): Ensemble learning, Five tribes in Machine Learning 17:50 Най-неизвестни спортисти, музканти, шофьори на камиони в България ... 19:10 Скандали в българската политика с Бойко Борисов, Кирил Петков, Асен Василев, Христо Иванов, ГЕРБ, ПП-ДБ, Демоктратична България ... 2 22:00 Анонс за дийпфейк филма "Властелинът на България 2". Първата част: https://youtu.be/VPj9L61R_Ak 23:09 Дали могат да програмират? ... 25:40 Обобщение Гледайте и другите клипове за работа с BGGPT и GPT2 в Google Colab и предстоящите, в които продължаваме с други модели, тестове и по-сложни обработки. Не забравяйте да подкрепяте "СВЕЩЕНИЯТ СМЕТАЧ", ако ви допада: абонирайте, споделяйте, коментирайте, харесвайте! Приемаме дарения и на компютърна техника, дискова памет, видеокарти. Благодаря! https://github.com/twenkid/ https://artificial-mind.blogspot.com/ https://github.com/Twenkid/Vsy-Jack-Of-All-Trades-AGI-Bulgarian-Internet-Archive-And-Search-Engine

Monday, April 15, 2024

The Sacred Computer's Discord Channel

Join The Sacred Computer Discord Chanel: https://discord.gg/qFQSvA2A3T

Wednesday, April 10, 2024

INSAIT ще си сътрудничат с TOYOTA за разработка на хуманоидни роботи: 22 години след оригиналния български проект в тази сфера и други

"INSAIT - Institute for Computer Science, Artificial Intelligence and TechnologyINSAIT - Institute for Computer Science, Artificial Intelligence and Technology | 14,283 followers

* INSAIT is proud to announce a new collaboration with Toyota! The collaboration is focused on the intersection of AI and robotics.

* The collaboration will begin by providing funding for PhD fellowships to pioneer advances in AI and robotics, paving the way for new and exciting breakthroughs.

* INSAIT is proud to collaborate with Toyota and welcomes the momentum and synergy that such opportunities generate!

Коментар на: Vassil Popovski

Technology and Product LeadershipTechnology and Product Leadership

Хейтърите - “Този институт нищо не прави и харчи 400 милиона държавни пари”

Реалността - големи компании партнират (и финансово подкрепят) с INSAIT - Institute for Computer Science, Artificial Intelligence and Technology защото виждат стойност в това което правят https://www.linkedin.com/in/vassil-popovski-38544a?miniProfileUrn=urn%3Ali%3Afs_miniProfile%3AACoAAAAQuZUBqKWSpqlkmch5Ne1ePkkLNJQYmXY&lipi=urn%3Ali%3Apage%3Ad_flagship3_detail_base%3BtpoxDWgnRC6d2Hw1hPaBdA%3D%3D

...

*Съкратен вариант в края -->

Браво на тях! Прота са! "Пари при пари отиват". Това че получават допълнително финансиране обаче не намалява държавната субсидия, а вероятно ще е довод тя да се увеличи, нали? :)) И не е вярно, че "хейтърите" казват, че INSAIT нищо не правят. ТЕ ПРАВЯТ, велики са, но на каква цена и кога го правят, как го правят, с кого, къде е корабът майка (не е в България)? Дали някой друг не може да го направи по-добре и по-евтино от тях и без да е франчайз на ETH, EPFL, MIT, HARVARD и WALLMART, с 1/10 или 1/100 от техния бюджет? Дали други не могат по-добре да създават такива неща: с много по-малко ресурси? Нали трябва "да се оптимизра", не ли така? :))) За сведение на "визионерите", имаше оригинален БЪЛГАРСКИ проект и в тази сфера*, създаден от БЪЛГАРИ, МЛАДЕЖИ, юноши, под 20-годишни :)))) от преди повече от 21-23 години :)))), които НИКОЙ чичко-паричко не подкрепяше, зад тях не бяха 3-4 университети с милиарди бюджет, стотици милиони левове пряко, не ги бяха галили три папи по главите и те имаха смелостта да представят такива проекти и работеха (и работят) по тях. ДЕЦА. И 20-25 години по-късно чичовци от чужбина, по на 45-50+ години, когато технологиите вече са "готови" и лесни, изливат се трилиони към опортюнистите и с няколко променени параметъра се създават "оригинални" открития, бълват се десетки хиляди почти едни и същи "оригинални" научни статии, ни обясняват колко това е "визионерско" и "иновативно" и лидери "на регионално ниво". Това е да си в КРАК С модата, а визионери бяха онези деца*. И даже имаше не един, а ДВА такива български проекта :))) от двама различни ТИЙНЕЙДЖЪРИ, един в Пловдив по-всеобхватен, за Универсален изкуствн разум, и един в София - за роботи, и се говореше и пишеше сериозно, задълбочено, пророчески, оригинално за универсални мислещи машини преди 21-23 години на БЪЛГАРСКИ език, "INSAIT", с това че ПОВТАРЯ (копира) тяхната работа е доказателство за ценността на техните работи. Имаше активен форум по AGI на БЪЛГАРСКИ език през 2004 г., говореше се за "трансхуманизъм", дума която някои професори по философия "дори не били чували" (цитирам един "визионер" докторант от 2022 г. когато го уведомих, че работата му е също закъсняла с 20 години, и му казах, че е смехотворно твърдението на един друг "визионер", И.С., който пише за трансхуманизъм, но съзнателно скрива и премълчава българската школа 15-20 години преди него). ИНСАИТ са с претенции, че са "родолюбци", а безсрамно копират (повтарят, преоткриват) оригиналната българска стратегия от 2003 г., като не цитират оригинала, въпреки че знаят за него. Само вие швейцарците ли сте българи, колега? В "сериозната наука" и академичното писане не се ли включваше глава "предишна работа", ако е известна - във всяка статия и дисертация? Тази стратегия също така беше предпоставка за първия в СВЕТА (не "в източна Европа" или "на балканския полуостров") курс по Artificial General Intelligence, 8 години преди MIT. 14 години по-късно INSAIT още нямат такъв курс. Онези българчета, ДЕЦА, имаха нужда само от хиляди, или милион-два милиона евро, с които да създадат "стартъпи" (едните деца даже го бяха направили), които с достатъчно тласък да се самофинансират, и да задвижат машините и да изградят средата още през 2000-те години и вече "всичко да е построено" (дали и сега няма да могат??? :))) ), а новите "визионери", изковали кариерите си и дошли на 45 години от "цивилизацията" да жънат реколтата, искат начален бюджет от стотици милиони САМО ЗА ДА ЗАПОЧНАТ и след още 10-20-30 години да дойде светлото бъдеще чрез тях.

Е те заради това "хейтят" някои "хейтъри" :)))) А не че от ИНСАИТ "не правят". Да обобщим: ТЕ ПРАВЯТ, браво, супер са! Обаче НА КАКВА ЦЕНА го правят и с каква реална цел? (Обобщение по този въпрос следва). Кибертрон, Бен Гьорцел, Хаотична логика - Общ изкуствен интелект 2 Twenkid Studio - Artificial Mind (todprog) | 524 абонати 35 показвания 11.03.2022 г. Общ Изкуствен Интелект - Универсален изкуствен разум (Artificial General Intelligence, AGI) Видео към първия в света курс по Универсален изкуствен разум, Пловдив 2010 г. "Други учени, изследователски групи... - Кибертрон, Бен Гьорцел, Хаотична логика", втора част. 2.avi, 2-chaotic.mp4 (Гличовете в звука свършват след 15 сек...) #изкуственинтелект #лекции #образование #интелект #роботи Гледайте и другите в плейлиста и: http://artificial-mind.blogspot.com https://youtu.be/t-p2ZrT4vqY?si=oqxjFYxCWGSYFNaK * Сега хуманоидни роботи проектира или произвеждат много компании и те надминават човешките движения в много параметри, като "Atlas" на BostonDynamics/Google. Тогава най-впечатляващият беше ASIMO на Хонда, който ходеше като "н.н." и се движеше бавно като човек, болен от паркинсон. Други "хейтъри" може да се изкажат, че проектът Кибертрон е бил "изпреварил времето" си в лош смисъл, че тогава е било "невъзможно". НЕ Е ВЯРНО. "Най-добрият начин да предвидиш бъдещето е като го изобретиш" - Алан Кей. * На снимката - от лекция към курса по Универсален изкуствен разум, 2010 г. вижда се датата долу вдясно. Това е Windows XP. На страницата пише, че през септември 2009 г. се навършват 7 години от началото на проекта "Кибертрон".

* Предишен пост от същия поучител (публичен):

https://www.linkedin.com/feed/update/urn:li:activity:7178677279785377792/

Vassil Popovski Technology and Product LeadershipTechnology and Product Leadership 2w • Edited • 2w • Edited •

Хейтърите (цитирам): "INSAIT взеха едни 400 милиона и чат бота им не знае коя е сестрата на Хисарския Поп"

Реалността: https://m.economy.bg/science/view/58082/Bezprecedentno-Bylgariya-v-evropejskiya-top-10-na-naj-avtoritetniya-forum-za-AI-v-sveta-

"Безпрецедентно: България в европейския топ 10 на най-авторитетния форум за AI в света Учени от INSAIT участват с 16 статии на конференцията CVPR 26 март 2024, 13:39

Българският институт INSAIT направи исторически пробив с 16 статии на конференцията CVPR – най-цитираният форум за изкуствен интелект и компютърно зрение в света. Този успех е безпрецедентен за страната ни в тази сфера и ни нарежда в топ 10 в Европа.

България има сумарно повече статии от всички държави в Източна Европа взети заедно. INSAIT изпреварва и всеки един университет от страни като Израел, Холандия, Финландия, Австрия, Дания, Естония, Норвегия, Швеция, Испания, Италия и други. Чрез INSAIT към Софийския университет „Св. Климент Охридски”, за първи път от 40 години учени от българска институция публикуват статии на този форум.

CVPR (хирш-5, индекс 422) е както най-авторитетният форум в областта на изкуствения интелект в света, така и на четвърто място сред всички научни форуми наред с Nature, The New England Journal of Medicine и Science. Статиите от INSAIT включват 6 стратегически направления като изкуствен интелект за разбиране на човешки движения, изкуствен интелект, който разбира видео, снимки и текст едновременно, автономно шофиране, генеративен AI, квантови изчисления за изкуствен интелект, изкуствен интелект за крайни устройства и други.

Институтът INSAIT към Софийския университет „Св. Климент Охридски” има стратегическата цел да превърне България във водещ център за изследвания и иновации в областта на информатиката и изкуствения интелект. Само преди месец институтът стана част от ELLIS – водещата европейска инициатива за изкуствен интелект. С това България стана първата страна в Източна Европа, която влиза в мрежата, където членуват Оксфорд, Кембридж, Макс-Планк и други."

Допълнителна бележка №1: 15 от 16-те статии са с участието на "българина" Ван Гуул в съавторство, като той е най-много 3-ти-4-ти (или един от последните автори), някои са със 7-8 автора. Често срещан трик, похват, страничен ефект на сериозните учени, пораснали в йерархията - всеки ръководител, чрез подчинените си поражда по множество статии, в които може да има минимално участие; и чрез съвместни проекти, което като дейност разбира се не е лошо нещо - да си надуват взаимно личния h-index и взаимно да си вдигат рейтингите и цитиранията. https://insait.ai/publications/

В една статия първият автор е българин - ученичката Рени Паскалева, браво на нея, и браво за това, че дават възможност на подобни деца да се изявяват (така както беше записано и в ОРИГИНАЛНАТА българска стратегия от 2003 г., която INSAIT повтарят - самият създател на стратегията, "моя милост", беше на 18 години, и една от целите на стратегията беше това продължение на Свещеният сметач да бъде: "Институтът ще изпълнява и ролята на "крило", което намира, "закриля и окриля" даровити хора, за да подпомага развитието им и, ако те пожелаят, да се радва на таланта им в изследванията. https://www.oocities.org/todprog/ese/proekt.htm

Сравни обаче с авторите от други институти "от Източна Европа".

INSAIT не е първият институт "на световно ниво" в източна Европа (разбира се, зависи от разтегливото определение "на световно ниво") - както невярно твърдят от самото начало, напоследък някъде смекчават "в региона", "в България". Подробности в други публикации и видео.

Бележка #2: Много изследвания/разработки в информатиката, които се водят наука, всъщност са инженерство (както би се изразил Ричард Файман, от една конференция), а не фундаментална наука.

Коментари към поста:

Todor Arnaudov

Founder & Research & Development at The Sacred Computer (Artificial Mind) - Interdisciplinary Institute for Artificial General Intelligence [Looking for Partners ]

4d

Браво на *ТЯХ* и на Ван Гуул, "про-та" са! Доколко успехът е "на/за България" е спорно. INSAIT има няколко първородни "гряха" и твърди неща, които са неверни :1) не е визионерски проект, защото по цели и по декларации е с ***20 години*** ЗАКЪСНЯЛО "очуждестранено" копие на истинския български проект за развитие на България с ИИ, с обявен 100-200 пъти раздут начален бюджет. Оригиналът е публикуван около май-юни 2003 г. на конкурса: "КАК БИХ ИНВЕСТИРАЛ 1 МИЛИОН С НАЙ-ГОЛЯМА ПОЛЗА ЗА РАЗВИТИЕТО НА СТРАНАТА". Има го архивиран тук: https://www.oocities.org/todprog/ese/proekt.htm Вижте и архива на "Капитал", победителите: реклама на кисело мляко и бира и "промяна на манталитета на българите". :)) Пророчествата от есето се сбъднаха на световно ниво и са размножени навсякъде. Защо дори не споменат оригиналната БЪЛГАРСКА работа щом го правят "за България"? Нима и ние не сме имали история и велики царе? Оригиналният "институт" е автор на "най-интелигентния речник" в света през 2007 г., създаден от един човек за 3 месеца от нулата: Smarty. Автор е и на ПЪРВИЯ В СВЕТА университетски курс по "Artificial General Intelligence" през 2010 и 2011 г. (Универсален изкуствен разум): 8 години преди курса "AGI" в MIT: без финансиране.(...) И др.

...

Vladimir Ivanov * 2nd degree connection 1w (edited)

Като всеки държавно подпомогнат проект е повече от естествено съмнението, че или едни пари са прибрани от наши хора или има някаква по-голяма далавера от това да се пишат научни статии, за която може само да гадаем. Но факт, че науката и образованието никога не са били приоритет на държавно финансиране, па сега...

See translationSee translation of this comment

Vassil Popovski Author Technology and Product Leadership 1w (edited)

Държава обаче тези пари не ги е дала още. Имаше обещания за около $10М на година. Повече за последната година са дошли от компании (Siteground - 12М лева, Google - $3M, VMware - $1.5M, Amazon - $1M, и много други). Не всичко в държавата ни е далаверки или наши хора. Сериозна наука се прави с много пари

[Тодор: Колко са скромни!!! "От Любов към България!" За истинските визионери, 20 години преди тях, които са си "жертвали кариерата", не се кланят на великите чужденци, които са "цивилизовали" "новите визионери" и работят безплатно, няма и една стотинка на година или на десет години.]

Vladimir Ivanov

Частично съм прав, явно няма далавера и какво друго да се присвоява...

Vassil Popovski "Сериозна наука се прави с много пари".

Todor Arnaudov • You

Founder & Research & Development at The Sacred Computer (Artificial Mind) - Interdisciplinary Institute for Artificial General Intelligence [Looking for Partners ]

4d

НЕ Е ВЯРНО. Да, ако под сериозна наука се разбира $$$$, "сериозните учени" я правят с много пари, защото умеят да се уреждат с тях и без пари нищо не вършат, както се изказва един колега в интервю, припомнено от БТВ, дали биха се върнали да работят за 1000 лв (през 2009 г.) Когато ИИ беше фантастика, двама студенти и Хинтън програмираха и обучиха AlexNet на две Geforce GTX 580 по 3 ГБ. Все едно сега две 3080 или 4080. Две 3090 са 2500-2600 лв втора ръка. Огромна част от следващите публикации на "най-престижните конференции" паразитират на подобни работи като променят дребни подробности. Първият в СВЕТА (не на "Балканския полуостров") курс по AGI се проведе в Пловдив с нулево финансиране (освен 200-тина лв хонорар за преподаването), а не в MIT или в ETH. https://artificial-mind.blogspot.com/2010/04/universal-artificial-intelligence.html

Шейн Лег, чували ли сте го, съосновател на Дийпмайнд, през 2011 ми писа, че се радвал, че съм намирал идеите му за ценни. :))))))

Тогава това не минаваше за "сериозна" наука, както може да прочетете подробно в книгата "Пророците на мислещите машини: Изкуствен разум и развитие на човека: История, теория и пионери".

Universal Artificial Intelligence (Artificial General Intelligence/AGI…

artificial-mind.blogspot.com

...

* Съкратен вариант на по-горния коментар: Браво! "Пари при пари отиват"! Но получаването на допълнителен приход от частни източници не намалява държавната субсидия, а е довод тя да се увеличи, нали? НЕ Е ВЯРНО, че "хейтърите" казват, че INSAIT нищо не правят. ТЕ ПРАВЯТ, велики са, но на каква цена, кога, как, каква е реалната цел, къде е "корабът майка"? Дали други не могат да разработят сравними и по-добри технологии по-евтино от тях и без да са франчайз на ETH, EPFL, MIT и WALLMART, с 1/10 или 1/100 от техния бюджет? В бизнеса не се ли "оптимизираха разходите"? Къде е конкуренцията? Освен българската стратегия на едно дете чудо от 2003, повторена (копирана) от INSAIT без да цитират оригинала, имаше и БЪЛГАРСКИ проект и в роботиката, създаден от друг младеж, около 19-годишен, преди повече от 21-22 години, за разработка на хуманоиден робот. 21 години по-късно чичовци от чужбина, по на 45-50 години, когато технологиите вече са "готови" и лесни, започвайки със стотици милиони начален капитал, ни поучават какви са ми ти "визионери", "предприемачи", "новатори", а ние простите "ганьовци" защо недоволстваме, нищо не разбираме... :))) Ние бяхме 21-22 години преди вас, чичовци псевдовизионери, и имаше не един, а ДВА български проекта от 2003-2004, от двама различни тийнейджъри.